Funktionsweise der Suchmaschine Google

Wie findet die Suchmaschine der Google die Webseiten ?

Google hat in einem distibuted Netz tausenden von preiswerten Computern deswegen kann Google eine schnelle Parallelverarbeitung durchführen. Die Parallelverarbeitung ist die Fähigkeit einer Instanz um mehrfache Arbeit oder Aufgaben gleichzeitig durchzuführen. Der Ausdruck wird sowohl für den Menschliche Erkennen als auch für den Maschinen in einem Zusammenhang mit der menschlichen Erkennens und - der Maschinenübertragen auf Lochkarten (Maschine computation) verwendet.

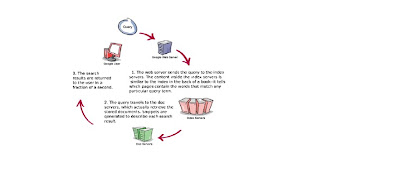

„Die Parallelverarbeitung ist auch ein Ausdruck für die parallele Datenverarbeitung . Google hat drei eindeutige Teile:

a) Googlebot, ein Web-Crawler, der die Webseiten findet und holt.

b) Der Indexe, der das jedes Wort auf jede Seite kategorisiert und den resultierenden Index von Wörtern in einer großen Datenbank sichert.

Alle Haupt-Suchmaschinen verwenden Spinnenprogramme (alias Crawler oder Roboter) um das Web zu reinigen und sammeln Dokumente, geben jedes eine eindeutige Referenz, scannen ihren Text und übergeben sie weg zu einem Index-Bewegung Programm.

Es gibt im Wesentlichen vier Möglichkeiten, in denen Google bot Ihre neue Site findet:

1)Die geläufigste Methode ist, Ihr URL bei Google für das Kriechen, über das „hinzufügen URL-“ Formular einzugeben bei www.google.com/addurl.html

2) Wenn Google ein Link von ihrer Seite bei eine anderen Site findet, die bereit bei Google indexiert hat.

3) wenn Sie sich für Googlewebmaster-Hilfsmittel anmelden oder ihr Sitemap eingeben wird Ihre Seite überprüft.

4)Wenn Sie eine bereits indexierte Webseite zum neuen umadressieren, paginieren Sie.

(Quelle :www.google.com Zugriff 03.05.2009)

(Quelle :www.google.com Zugriff 03.05.2009)Es gibt keine Unternehmensgarantien hinsichtlich, wie schnell neue Sites - oder Seiten - durch Google und im Rechercheindex dann zu erscheinen gekrochen werden. Jedoch einer der vier Aktionen oben folgend, würden Sie normalerweise erwarten, innerhalb eines Monats gekrochen zu werden und Ihre Seiten, nach zwei bis drei Wochen indexiert sehen. Die Unterordnung über Googlewebmaster-Hilfsmittel ist die meiste effektive Weg um indexiert zu sein. Sobald Google bot auf Ihrer Site ist, kriecht es jede Seite der Reihe nach. Wenn es ein internes Link findet, erinnert sich es an.

Um Googlebotskriechen in ihrer bestimmten Seiten zu verhindern, ist die beste Methode eine robots.txt-Datei zu benutzen. Dieses ist einfach eine ASCII-Textdatei, die Sie an der Wurzel Ihres Gebietes platzieren.

Zum Beispiel wenn Ihr Gebiet http://www.yourdomain.com ist, platzieren Sie die Datei bei http://www.yourdomain.com/robots.txt.

Sie verwendeten möglicherweise robots.txt, um Google zu verhindern, das Ihre Bilder indexiert, Ihre Perl-Skripte laufen lässt oder auf Seiten zugreift, die urheberrechtlich geschützt sind. Jeder Block der robots.txt-Datei druckt zuerst den Namen der Spinne, dann die Liste der Verzeichnisse. Das Format unterstützt den Gebrauch von Wildcardzeichen, wie „*“ oder „?“ zu Zahlen oder Zeichen darstellen.

Die folgende robots.txt-Datei würde verhindern, dass alle Roboter auf Ihre Bild- oder Perl-Skriptverzeichnisse und gerade Google bot vom Zugriff Ihrer urheberrechtlich geschützten Material- und Urheberrechtsvermerkseite zugreift (das Annehmen Sie hatte Bilder in ein „Bild“ Verzeichnis und in Ihr urheberrechtlich geschütztes Material in einem „copyright“ Verzeichnis) gelegt:

User-agent: *

Disallow: /images/

Disallow: /cgi-bin/

User-agent: Googlebot

Disallow: /copyright/

Disallow: /content/copyright-notice.html

Um Googlebots Schleichenkinetik zu steuern, müssen Sie dich für Googlewebmaster-Hilfsmittel anmelden. Sie können von einer von drei Einstellungen für Ihr Schleichen wählen: schneller Normal oder langsameres. Normal ist die Nichterfüllung (und empfohlene) Schleichkinetik. Ein langsameres Schleichen verringert Googlebots Verkehr auf Ihrem Server, aber Google kann möglicherweise nicht in der Lage sein, Ihre Site häufig zu kriechen. Sie sollten beachten, dass keine dieser Schleichanpassungsmethoden zuverlässiges 100% ist.

Keine Kommentare:

Kommentar veröffentlichen